卷积神经网络

全连接神经网络:

- 参数太多

- 训练困难

- 网络结构复杂

- 没有考虑到图像的空间结构信息

动机

比起浅层神经网络,深度神经网络会更难训练,然而,如果训练好一个深度网络,它会比浅层网络强大的多

因此,有必要开发一种能够训练的深度网络结构

卷积神经网络可以简化网络结构,同时利用空间结构信息

卷积神经网络

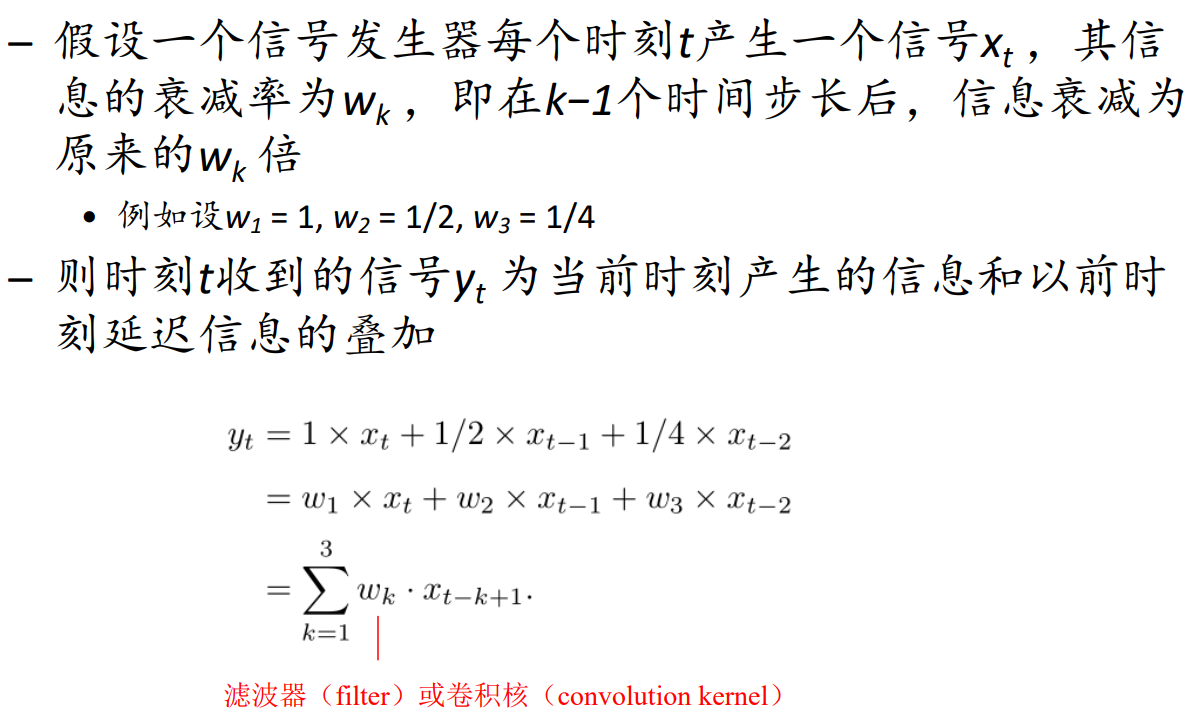

卷积运算

卷积经常用在信号处理中,用于计算信号的延迟累积

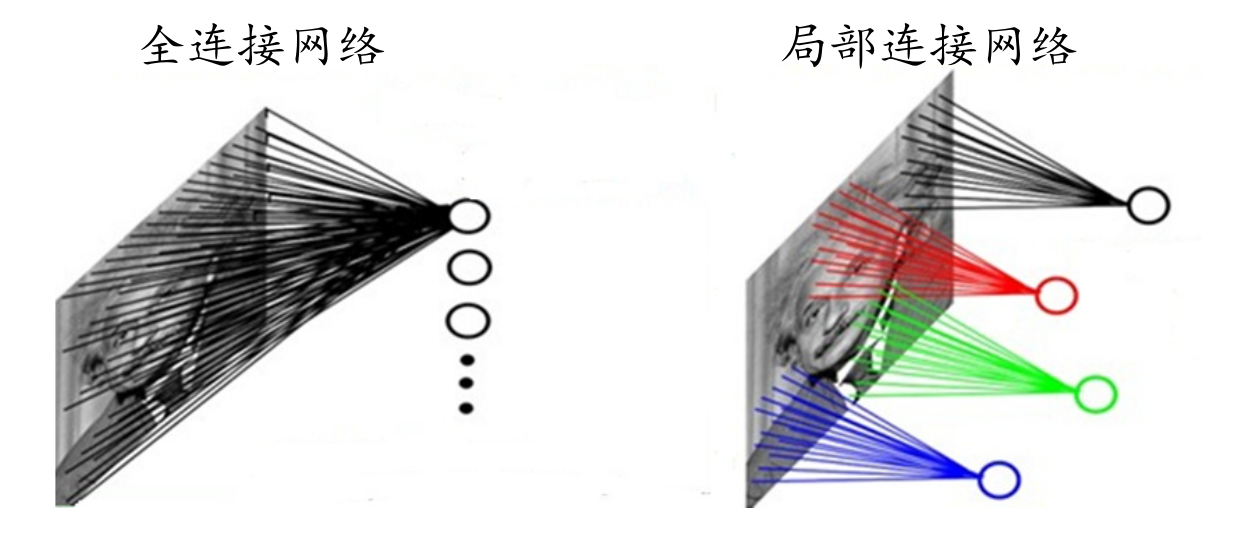

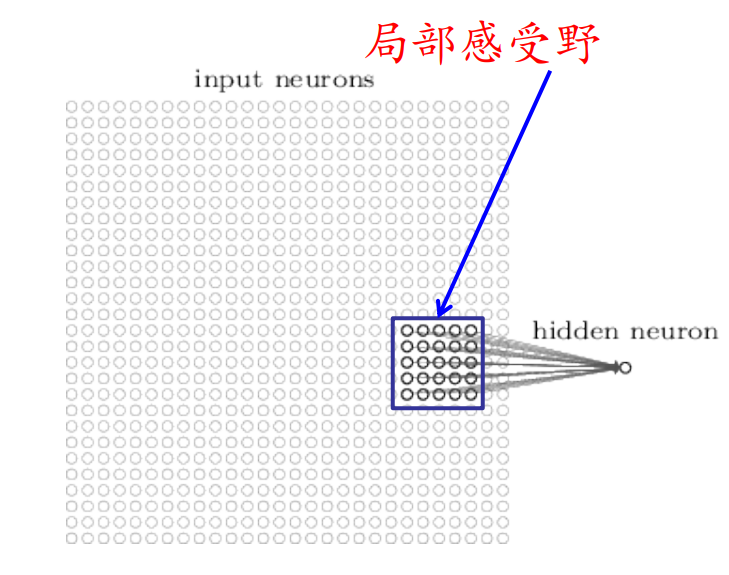

局部感受野

单个视觉细胞仅对部分区域的特定模式反应

局部感受:对外部世界由局部到全局的感知

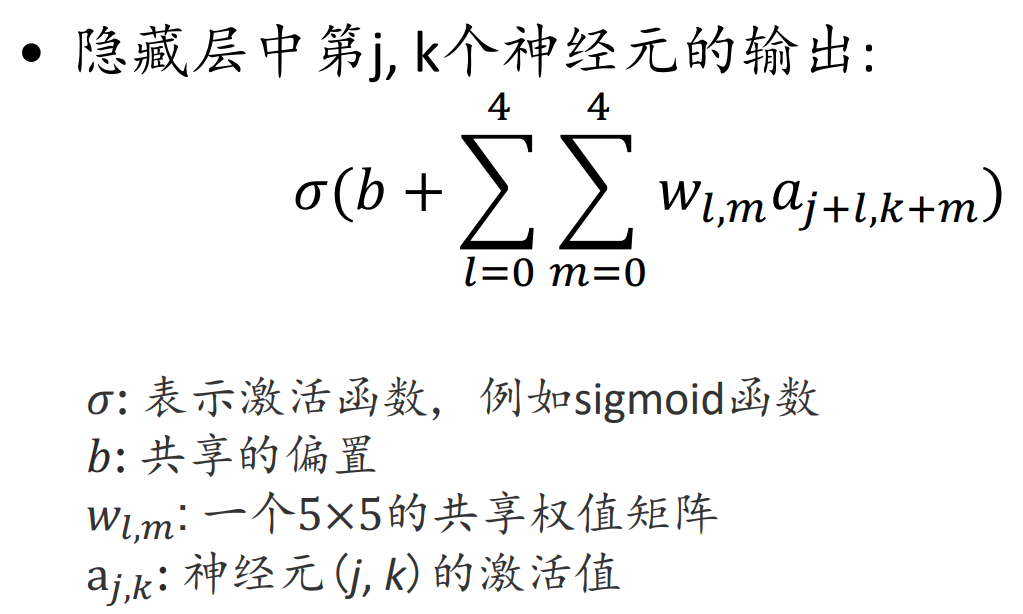

一个小区域的输入像素连接到隐藏层的一个神经元

输入图像中的此类区域称为隐藏神经元的局部感受野

然后在整张图片上滑动这个局部感受野,每个不同的局部感受野对应于隐藏层的一个不同的神经元

权值共享

每个隐藏层神经元使用相同权值与偏差

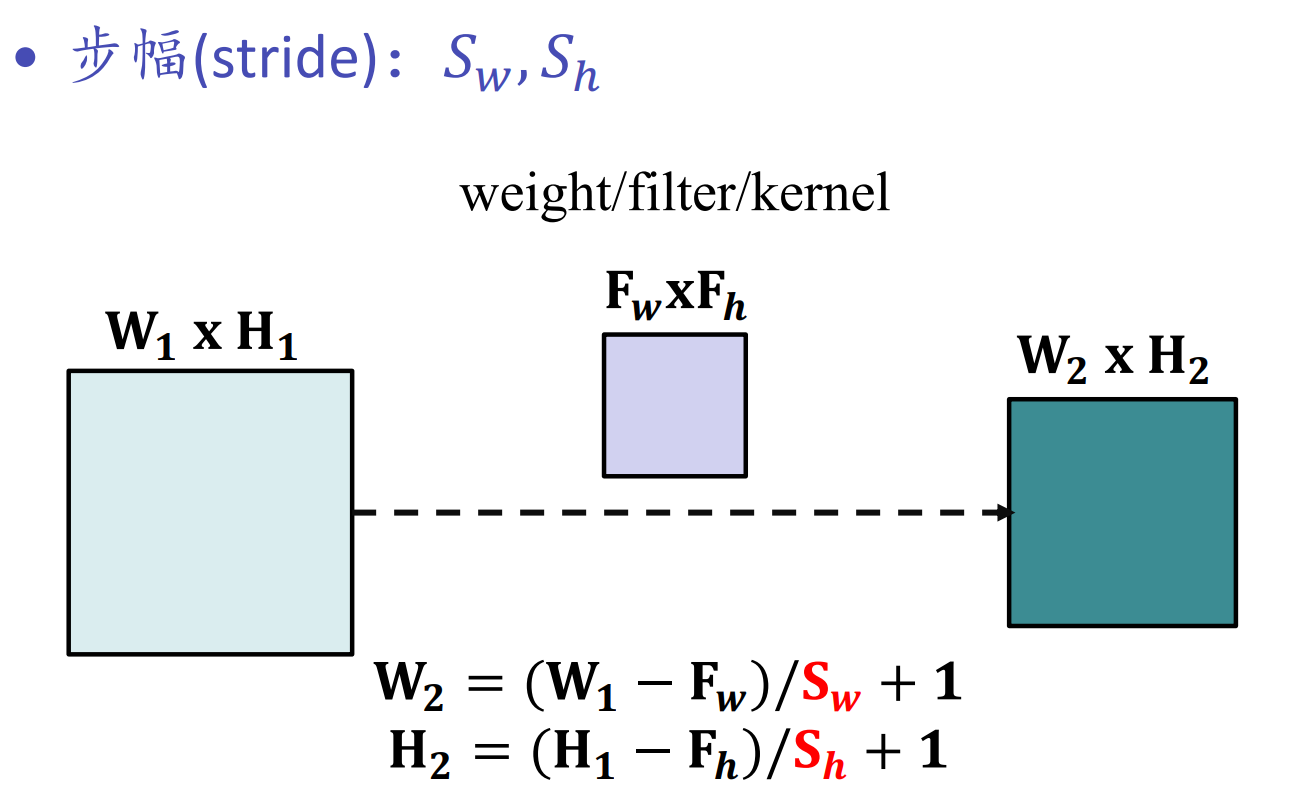

步长(Stride):每次局部感受野移动的幅度。相邻的子区域很相似,没有必要检测所有的子区域

第一个隐藏层中所有神经元都检测到了相同特征,只是在不同的输入图像的位置

因此,从输入层到隐藏层的映射通常称之为特征映射(feature map)

共享的权值和偏置被称为卷积核(kernel)或者滤波器(filter)

滤波器越多,特征映射的深度越大,得到的关于输入的信息就越多

共享权值极大降低了CNN的参数规模

池化

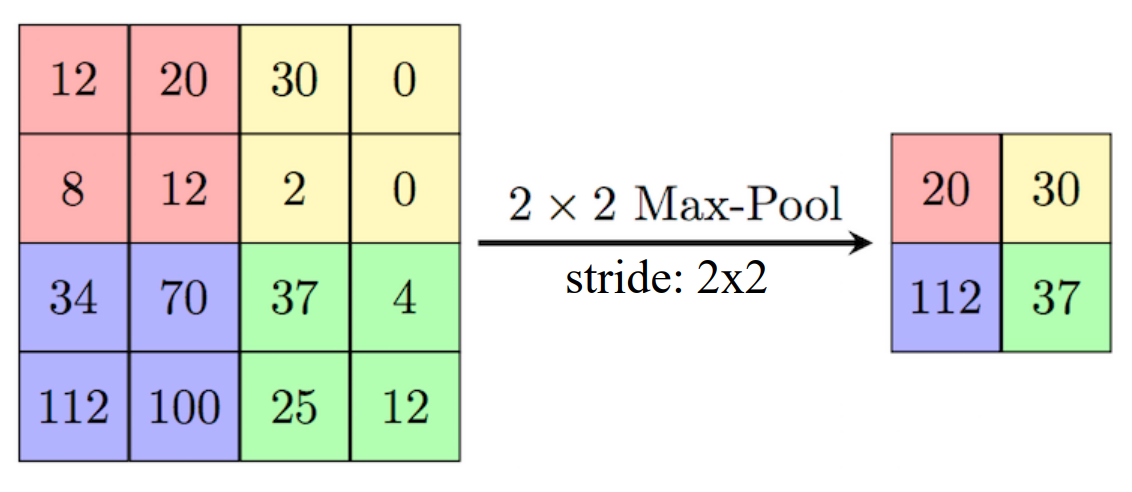

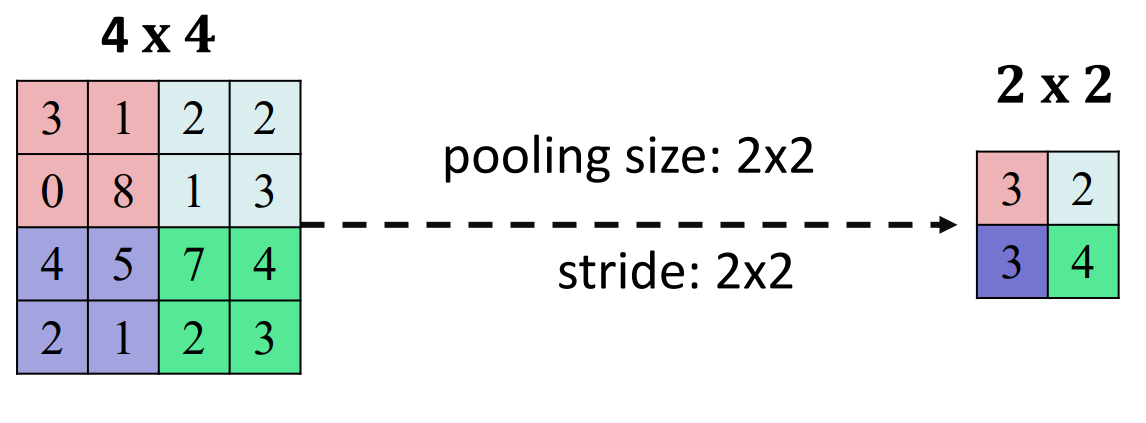

池化层通常用在卷积层之后,以简化卷积层输出的信息

- Max-pooling:输出池化矩阵中最大激活值

- Mean-pooling:

池化的主要目的:

- 减少参数,降低计算量,控制过拟合

- 使得特征具有局部的转移和扭曲不变性

卷积神经网络中的反向传播

典型的卷积网络

- ImageNet

- LeNet

- AlexNet

- VGGNet

- GoogLeNet

- ResNet

应用

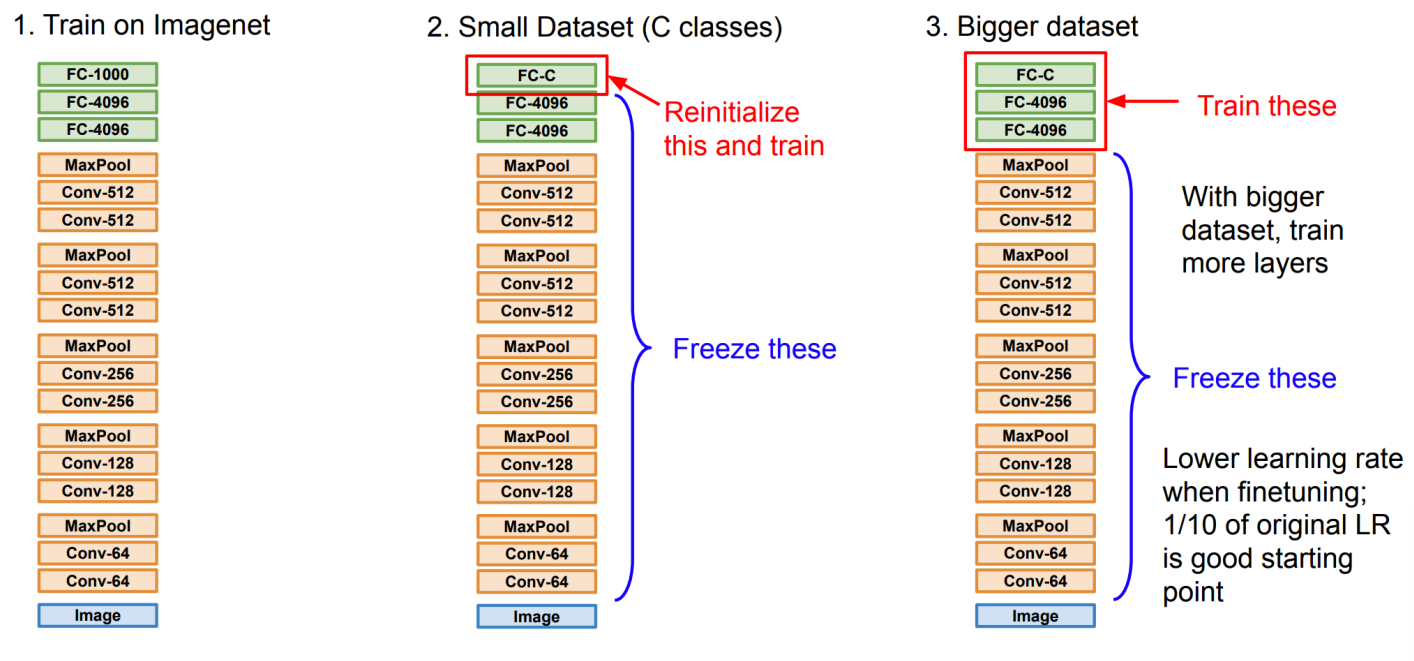

CNNs迁移学习框架

图像描述生成

图像表征提取

卷积神经网络

http://example.com/2024/11/27/Notes/课程/大三(上)/神经网络与深度学习/卷积神经网络/